Al pari delle tanto odiate fake news che diffondono bufale ogni giorno, anche il Deepfake è un fenomeno che genera disinformazione ed inganno. Se il secondo non è diffuso come le prime, non si può negare che il fenomeno sia in continua espansione. Ma di cosa si tratta e com’è possibile combatterlo sfruttando l’intelligenza artificiale su cui anch’esso si basa? Vediamo di fare un po’ di chiarezza anche perché se da un lato si prova a combattere il fenomeno, dall’altro il fenomeno stesso pare aver trovato una scappatoia.

Deepfake, come funziona il fenomeno dei video fake

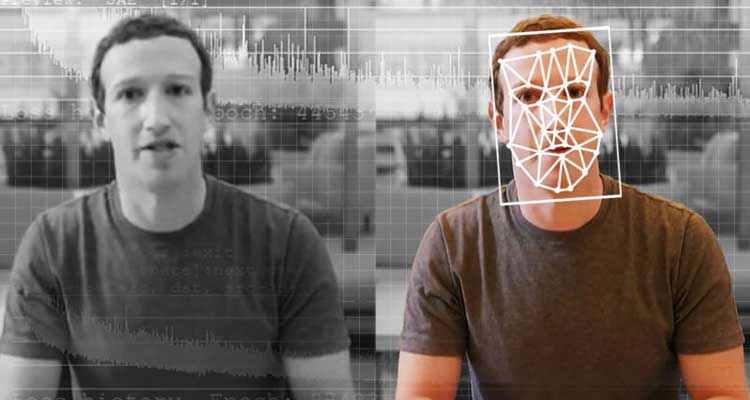

Deepfake non è un termine di nuova accezione dal momento che circola ormai da qualche anno. Era il 2017 quando compariva per la prima volta per indicare i video fittizi che immortalano personaggi (noti o meno) ma che sono fasulli proprio perché ricreati ad arte. Per creare il video di un personaggio che, ad esempio, si comporta in maniera sconveniente, è sufficiente sovrapporre alcune immagini della persona in questione a filmati girati in separata sede.

Il risultato è un video (o in vari casi un’immagine) che ritrae la “vittima” in un atteggiamento mai avuto. Ed è chiaro che un evento di questo tipo possa rivelarsi davvero molto dannoso per la reputazione della persona. Un cenno merita la modalità in cui i deepfake nascono. La tecnica, sempre più perfezionata, si basa sull’intelligenza artificiale mediante cui si procede alla ricostruzione artificiosa di volti e voci che riescano a simulare le riprese video effettuate dalle telecamere.

Il lavoro dei rilevatori e le falle

A cercare di arginare il problema dei Deepfake pensano i cosiddetti rilevatori. Come si evince dal loro nome, si tratta di strumenti specificatamente pensati per rilevare i video fasulli. Lavoro che, occorre precisarlo, spesso è molto complicato dal momento che le tecniche di creazione si sono parecchie perfezionate con il tempo. In un contesto come questo, è stata identificata una falla che consente ai creatori di video fasulli di eludere i rilevatori e passare, quindi, indenni dai controlli.

In base a quanto svelato da un gruppo di studiosi americani, basterebbe inserire in tutti i fotogrammi dei video fasulli i cosiddetti “esempi contraddittori”. Di cosa si tratta? Semplicemente immagini che, con la corretta manipolazione, possono mandare “in tilt” l’intelligenza artificiale impedendole di rilevare i Deepfake. Il lavoro di chi vuole contrastare questo fenomeno è, quindi, molto impegnativo e va di pari passo con l’ingegno dei malintenzionati che, invece, producono giorno dopo giorno video così ingannevoli.

Tech for Dummies

Tech for Dummies